2025.07.09 / 넥스트플랫폼 동준상 프로

저의 고객사에서 AWS Bedrock (이하 베드락 혼용) 기반으로 자체 LLM 지식기반을 구현했고 현재는 AX 변화관리 및 조직확산을 준비중인데요, LLM 지식기반에 대한 사용 방법이나 비용, 보안, 거버넌스에 대해 궁금증을 풀어드리기 위해 가볍게 핸즈온하면서 해당 내용에 대해 설명하는 포스트입니다.

- 2부. AWS Bedrock 핸즈온

- 1부. AWS, Azure, 네이버의 LLM SaaS 서비스 비교

2부. AWS Bedrock 핸즈온

- 고객사의 임직원들께서는 Anthropic (이하 앤스로픽 혼용) 모델 기반으로 업무 수행을 위한 질의를 많이 하시는데 때론 그 모델이 돌아가는 아랫부분 (AWS Bedrock)이 어떻게 생겼는지, 어떤 방식으로 작동하는지 알아야 할 때가 있지요.

- 특히 (현재는 매월 1천만원 미만이지만) 앞으로 매월 수천만원~수억원의 SaaS 비용이 발생하게 될 것이므로 비용 구조를 알고 싶다면 기반모델(FM)이 실행되는 AWS Bedrock 같은 클라우드 인프라/플랫폼/서비스를 알 필요가 있습니다.

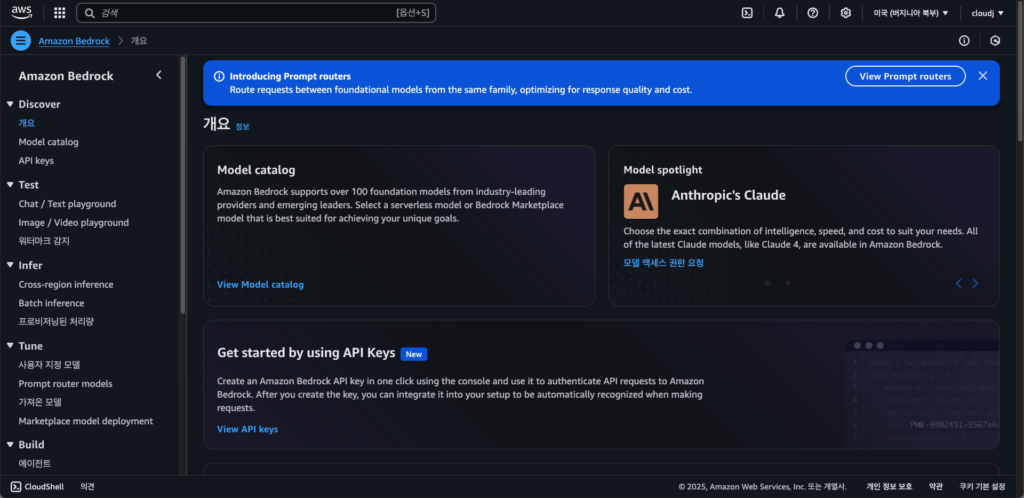

1. AWS 콘솔 로그인 후 베드락에 접속

아래 주요 메뉴에서 클라우드 LLM SaaS로서 중요한 부분은 세 번째 열, Build에 포함돼 있네요. 고객사 LLM에도 거의 같은 메뉴들이 존재하고요, 에이전트, (워크)플로우, 지식기반, 가드레일 등이 기업 레벨의 AI 서비스 구현에 직접 활용하는 요소들입니다.

| Discover – 개요 – Model catalog – API keys Test – Chat / Text playground – Image / Video playground – 워터마크 감지 | Infer – Cross-region inference – Batch inference – 프로비저닝된 처리량 Tune – 사용자 지정 모델 – Prompt router models – 가져온 모델 – Marketplace model deployment | Build – 에이전트 – 플로우 – 지식기반 – 가드레일 – 프롬프트 관리 – 데이터 자동화 Assess – Evaluations Configure – 설정 – 모델 액세스 |

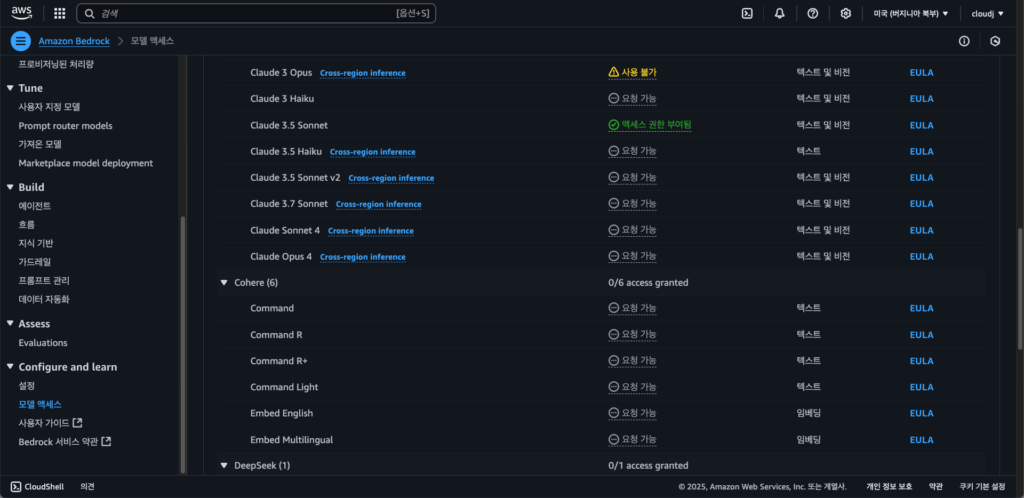

(핸즈온 영상에서 보시겠지만) 가장 먼저 Configure 메뉴의 ‘모델 액세스’를 통해 기반모델을 하나 연결해주고 테스트, 비용 추정 등 필요한 작업을 진행합니다.

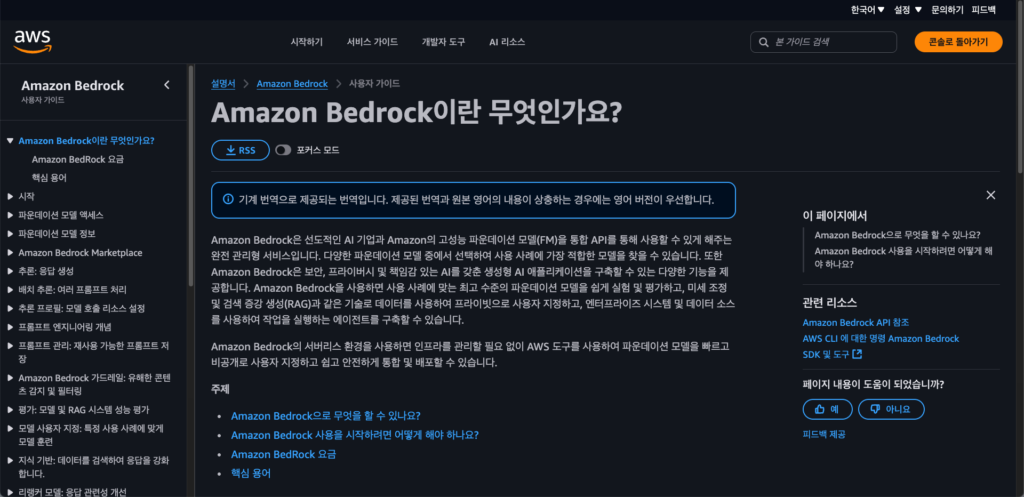

2. Amazon Bedrock이란?

(앤스로픽 등) 선도적인 AI 기업과 Amazon이 만든 고성능 파운데이션 모델(FM)을 통합 API를 통해 사용할 수 있게 해주는 완전 관리형 서비스

- 다양한 파운데이션 모델 중에서 선택하여 사용 사례에 가장 적합한 모델 선택 가능

- 보안, 프라이버시, 책임감 있는 AI 기반의 생성형 AI 애플리케이션 구축 체계

- 기업, 기관별 사용 사례에 맞는 최고 수준의 파운데이션 모델 실험 및 평가

- 미세 조정 및 검색 증강 생성(RAG)과 같은 기술로 데이터를 사용하여 프라이빗 접속 지원

- 엔터프라이즈 시스템 및 데이터 소스를 사용하여 작업을 실행하는 보안, 거버넌스 기반 에이전트 구축 가능

네, 이런 이유로 국내외 탑티어 기업들이 클라우드 LLM SaaS를 활용해서 자체 LLM 서비스를 구현하고 있습니다. 물론 내부적으로 프라이빗 인프라에 LLM을 구현한 경우보다는 최소 30~50%의 높은 비용을 지불해야 할 것입니다.

링크 | Amazon Bedrock 사용자 가이드

https://docs.aws.amazon.com/ko_kr/bedrock/latest/userguide/what-is-bedrock.html

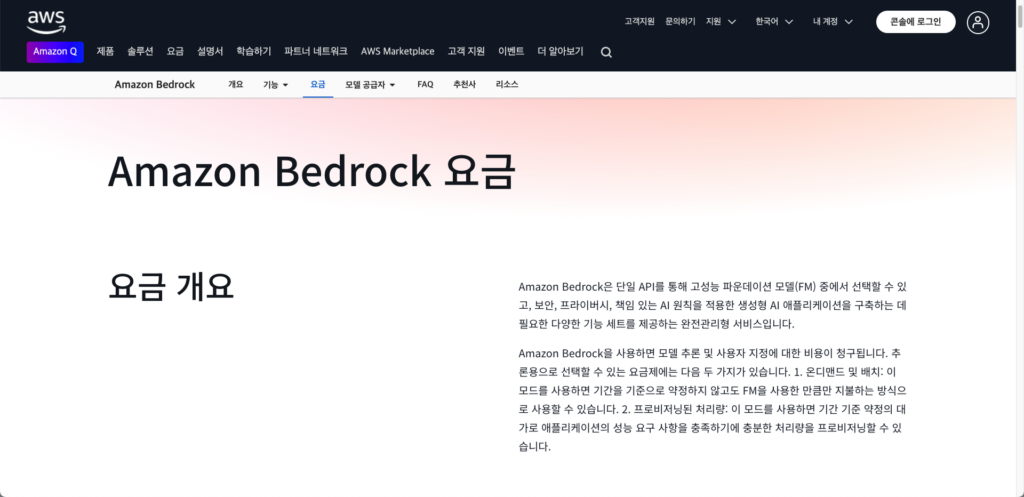

3. Bedrock 비용

머신러닝, 딥러닝 등 이전 세대 AI 서비스인 SageMaker도 결코 저렴한 서비스가 아니었는데요, 훨씬 큰 용량의 인스턴스를 기반으로 실행되는 LLM 서비스인 Bedrock을 방심하고 썼다가 ‘한 달만에 1년치 지식기반 예산을 다 써버리는 게 아니냐’하는 우려가 있습니다.

일단 직접적으로 드러난 요금을 보면 입력과 출력 작업 사이에 큰 비용 차이가 있다는 것을 알 수 있습니다.

베드락에서 Anthropic (이하 앤스로픽 혼용) 모델을 선택하면 (요즘 많이들 사용하시는 소넷 기준) 1000토큰 당 0.003달러가 과금됩니다.

| Anthropic 모델 | 입력 토큰 1,000개당 요금 | 출력 토큰 1,000개당 요금 |

| Claude Opus 4*** | 0.015 USD | 0.075 USD |

| Claude Sonnet 4*** | 0.003 USD | 0.015 USD |

Claude 3.5 Haiku | 0.0008 USD | 0.004 USD |

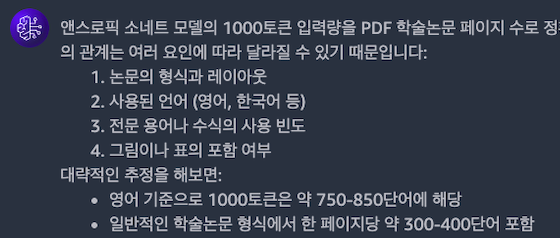

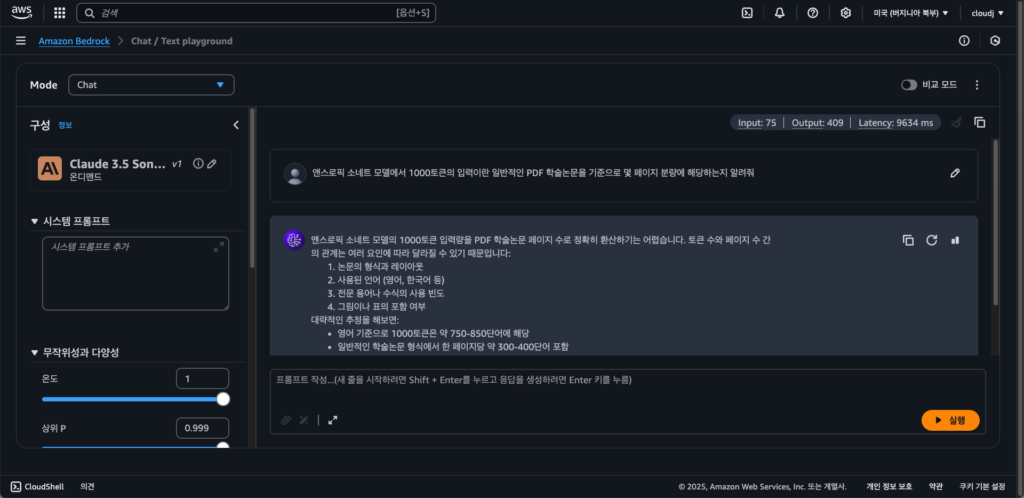

‘1000토큰’이라는 개념이 늘 문제인데요, 우리가 사용하는 단어수, 페이지수와는 다른 LLM 처리 단위라서 감이 잘 안 잡히고요, 이럴땐 클로드한테 물어봐야죠.

네, 1000토큰은 PDF 논문 1.5~2페이지 분량쯤 되는 텍스트네요. 제가 하루 종일 GPT에게 업무적으로 질의하는 양이 최대 10페이지 정도 되니까 하루 베드락 ‘기본 비용’은 0.015달러 정도 되는군요.

클라우드 LLM 비용에 대한 방심은 금물

우선, 베드락 / 앤스로픽 / 소넷의 비용은 조건에 따라 달라집니다. 이는 클라우드의 기능 세분화, 과금 세분화 정책이 반영된 결과입니다. 실시간, 배치(일괄처리), 캐시(임시저장으로 신속) 방식에 따라 요금제가 달라지고 임직원수, 사용방식에 따라 꽤 큰 비용 차이가 발생할 수 있습니다.

| Anthropic 모델 | 입력 토큰 1,000개당 요금 | 출력 토큰 1,000개당 요금 | 입력 토큰 1,000개당 요금(배치) | 출력 토큰 1,000개당 요금(배치) | 입력 토큰 1,000개당 요금(캐시 쓰기) | 입력 토큰 1,000개당 요금(캐시 읽기) |

| Claude Opus 4*** | 0.015 USD | 0.075 USD | 해당 사항 없음 | 해당 사항 없음 | 0.01875 USD | 0.0015 USD |

| Claude Sonnet 4*** | 0.003 USD | 0.015 USD | 해당 사항 없음 | 해당 사항 없음 | 0.00375 USD | 0.0003 USD |

Claude 3.7 Sonnet*** | 0.003 USD | 0.015 USD | 해당 사항 없음 | 해당 사항 없음 | 0.00375 USD | 0.0003 USD |

Claude 3.5 Sonnet** | 0.003 USD | 0.015 USD | 0.0015 USD | 0.0075 USD | 0.00375 USD | 0.0003 USD |

Claude 3.5 Haiku | 0.0008 USD | 0.004 USD | 0.0005 USD | 0.0025 USD | 0.001 USD | 0.00008 USD |

다음, 클라우드는 대체로 입력은 저렴하게, 출력은 비싸게 책정된다는 점을 고려해야 합니다. 예를 들어 무제한의 저장용량을 제공하는 객체스토리지이자 데이터 레이크인 S3의 경우, 데이터 입력(저장)은 무료이지만 그 이후의 모든 작업은 과금 대상입니다.

즉, 위 표를 보면 Claude 3.5 Sonnet에 사용자가 질의하는 비용에 비해 클로드가 응답하는 비용은 5배 비싸게 책정된 것을 알 수 있습니다. 그리고 보통 사용자의 질의가 10단어라면 LLM은 보통 50단어~100단어 수준으로 응답을 하므로 배수의 배수 효과가 발생합니다.

예를 들어 이번 사용자의 질의 비용이 50원이라면, 클로드 소네트의 응답 비용은 과금 배수에 표시된 5배인 250원이고, 여기에 정보량 배수 4~5배를 곱하면1000원선까지 비용이 증가할 수 있습니다.

클라우드 SaaS LLM의 비용, 보안, 거버넌스에 대한 내용은 다른 포스트에서 다루겠습니다.

4. 핸즈온: Configure >> 모델 선택으로 시작

테스트 채팅 핸즈온을 위해 먼저 모델을 선택합니다. 이미 클로드 3.5 소넷이 선택돼 있는데 하나 더 연결해 보겠습니다.

이제 테스트 채팅을 수행하며 우리가 평소에 쓰던 클로드의 느낌이 맞는지, 엔터프라이즈 환경에서 우리 임직원들께서 더 필요로 할 요소는 없는지 판단해 볼 수 있습니다.

핸즈온 영상에서 좀 더 자세한 활용 방법을 소개합니다.

1부. AWS, Azure, 네이버의 LLM SaaS 서비스 비교

1. LLM SaaS 서비스 개요 비교

| 항목 | AWS | Azure | Naver Cloud |

|---|---|---|---|

| 서비스명 | Bedrock | Azure OpenAI Service | CLOVA Studio |

| LLM 모델 | Anthropic Claude, Mistral, Meta LLaMA, Amazon Titan 등 | OpenAI GPT-4, GPT-3.5 등 | HyperCLOVA X |

| 제공방식 | API 기반 통합 플랫폼 | API, Azure Studio, Notebook | 웹 기반 Studio 및 API |

| 초점 영역 | 멀티모델 접속, 엔터프라이즈 확장성 | OpenAI 기반 모델 고도화 | 한국어 초거대언어모델 특화 |

2. 기술적 특징 비교

| 항목 | AWS Bedrock | Azure OpenAI | Naver CLOVA Studio |

|---|---|---|---|

| 파인튜닝 | Retrieval Augmented Generation (RAG), Guardrails 지원 | GPT 모델 fine-tuning 가능 (Enterprise 계정) | Prompt 조정, Fine-tuning (Beta) |

| 멀티모델 | 다양한 서드파티 모델 탑재 | GPT 시리즈 집중 | HyperCLOVA X 단일모델 |

| 보안/컴플라이언스 | IAM 통합, Private VPC 옵션 | Microsoft Entra, 지역 데이터 통제 | 국내 규제 대응 최적화 |

| 생성형 워크플로우 | Amazon Agents for Bedrock | Logic Apps 및 Copilot 통합 | 자연어 API + 요약, 번역, QA 워크플로우 |

3. 장단점 분석

| 플랫폼 | 장점 | 단점 |

|---|---|---|

| AWS Bedrock | 다양한 오픈 LLM 모델 통합, RAG와 엔터프라이즈 기능 강점 | 한국어 성능 상대적 열세, UI 진입 장벽 |

| Azure OpenAI | GPT-4 기반 고품질 생성, Microsoft 365 Copilot과 통합 가능 | 모델 선택 제한적, 리전 제약 발생 가능 |

| Naver CLOVA | 한국어 최적화, 국내 클라우드 환경 최적화, 쉬운 웹 기반 사용 | 글로벌 모델 다양성 부족, 확장성 제한 |

4. 가격 정책 및 국내 활용성

| 항목 | AWS | Azure | Naver |

|---|---|---|---|

| 요금 방식 | Token 기반, 온디맨드 요금제 | Token 기반, 예약 인스턴스 제공 | 요청 단가제 + 월간 패키지 |

| 한국 리전 지원 | 서울 리전 | 한국 중부, 남부 | 완전한 국내 운영 |

| 지원 언어 | 영어 중심, 일부 한국어 | 영어 중심, GPT는 한국어 우수 | 한국어 특화 |

| 국내 기업 적합도 | 글로벌 협업 조직에 적합 | Microsoft 제품군 도입 기업 적합 | 공공, 금융, 교육, 스타트업에 적합 |

5. 선택 가이드 및 추천 시나리오

- 글로벌 협업 중심 기업 → Azure OpenAI / AWS Bedrock

(Copilot 도입, 멀티모델 API 통합 필요 시) - 국내 시장과 한국어 기반 서비스 필요 → Naver CLOVA Studio

(공공기관, 교육, 금융권 등) - RAG, 엔터프라이즈 보안 강화, 다양한 모델 테스트 목적 → AWS Bedrock

(Anthropic Claude, Meta LLaMA, Amazon Titan 활용 등)

지속적으로 업데이트되는 포스트입니다. / 첫 포스팅: 250709 / 이 포스트에 대한 문의 및 요청: naebon@naver.com