25.11.17 / JUN

AI 클라우드 서비스 도입, 기획, 배포를 준비중인 기관, 기업, 조직의 업무 담당자를 위한 Azure, GCP, AWS 기반의 AI 클라우드 실무 교육 과정입니다. 사례와 실습 중심으로 진행되며, GPT, Claude API 실습부터 컨테이너·서버리스 배포,AI 아키텍처 보고서 작성까지 완성하는 과정입니다.

공지사항

- ! 원활한 실습 참여를 위해 Azure, GCP, AWS 등 주요 퍼블릭 클라우드 서비스에 대한 회원 가입이 필요합니다.

- ! 프리티어 수준에서 실습을 진행하지만 각자 사용한 클라우드 리소스에 대해 소정의 과금이 청구될 수 있습니다.

- ! 클라우드 환경에 배포하는 용도로 GPT API, Gemini API를 연계한 웹앱을 바이브코딩 방식으로 빌드하며, 각자 보유한 계정의 GPT API 토큰이 소모됩니다.

AI 클라우드 기획-구현-배포 지원 도구

- 기획, 설계 도구: GPT, Claude

- 바이브코딩 도구: Cursor, Kiro

미니 프로젝트 수행

AI 클라우드 설문 및 미니 프로젝트 주제 선정

https://forms.gle/hq3KDzBMYesFTxJK7

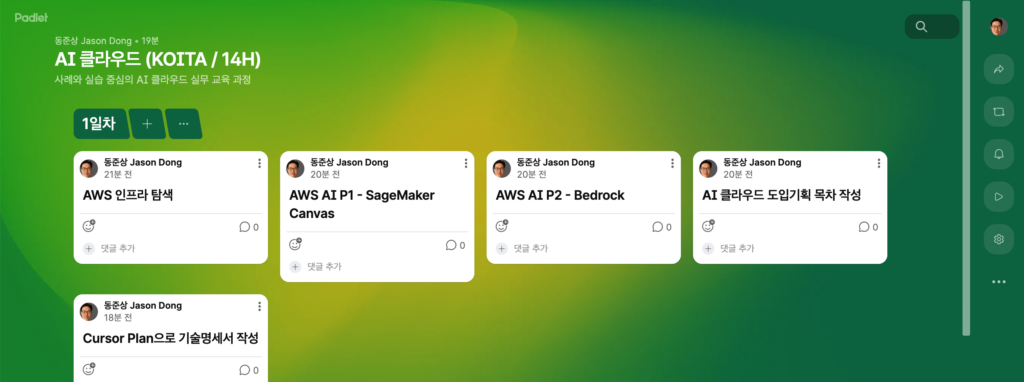

강연 흐름 공유

패들렛 공유 | AI 클라우드 (KOITA)

https://padlet.com/naebon1/ai_cloud_essential

📘 강의 개요

AI 전환 시대, 클라우드는 더 이상 단순한 인프라가 아닌 **‘AI 혁신의 운영체제’**로 자리잡았습니다. 본 과정은 최신 AI 클라우드 기술 트렌드부터 서비스 기획, 앱 개발, 서버리스 배포, 아키텍처 보고서 작성까지 2일(총 14시간)에 걸쳐 완성하는 실습 중심 AI 클라우드 마스터 과정입니다.

수강생은 GPT·Claude 기반의 생성형 AI API를 직접 다루며, Cursor + GitHub를 활용해 AI 클라우드 앱을 기획·개발·배포·보고서화하는 전 과정을 경험하게 됩니다.

1. 수강고객 전용자료

1.1 기본교재 다운로드 (수강고객용 / GPTs 지식 업로드 버전)

지금은 다운로드 기간이 아닙니다.

1.2 AI 클라우드 기획, 분석, 리서치 특화 GPTs

https://chatgpt.com/g/g-690f599eb6408191b381cf1b31967333-nova-ai-cloud-planner-gpts

2. 글로벌 3대 클라우드

2.1 AWS

https://aws.amazon.com/

Dataset: Amazon SageMaker Canvas Immersion Day

https://catalog.us-east-1.prod.workshops.aws/workshops/80ba0ea5-7cf9-4b8c-9d3f-1cd988b6c071/en-US

3. AI 기반 소프트웨어 기획-개발-배포 도구

3.1 Github

https://github.com/

3.2 Cursor (1일차)

https://cursor.com/download

3.3 Kiro (2일차)

https://kiro.dev/

👥 권장 수강 대상

| 대상군 | 상세 설명 |

|---|---|

| 🧩 기술기획자 | AI 서비스용 클라우드 도입 전략을 수립해야 하는 R&D·기획 담당자 |

| 💡 AI/ML 기획자 | Generative AI, ML, LLM 기반 서비스 구상을 준비 중인 실무자 |

| 🧠 데이터 분석가 | AI 분석 파이프라인 및 클라우드 데이터 운영을 검토 중인 담당자 |

| 🧑💻 엔지니어 및 연구원 | Azure·GCP·AWS 기반 AI 앱 배포 및 운영 역량을 향상하고자 하는 기술 인력 |

| 🏢 기관/기업 관리자 | AI 클라우드 도입 시 비용·보안·거버넌스 등 의사결정을 지원해야 하는 관리자 |

🧭 커리큘럼 (2일 / 14시간)

| Phase | 주제 | 주요 내용 |

|---|---|---|

| DAY 1 | ||

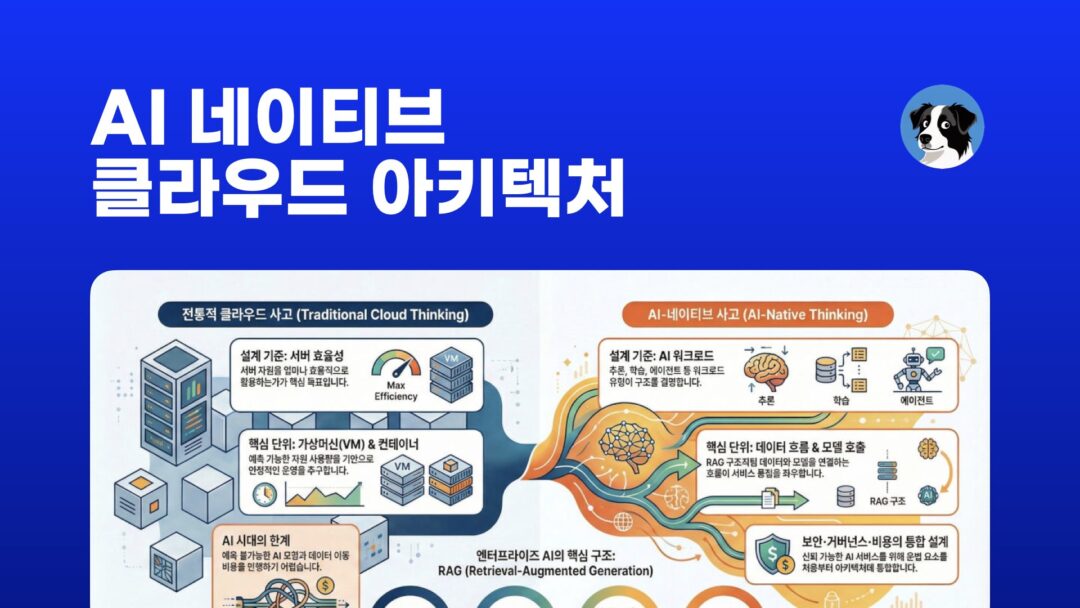

| Part 1 | AI 클라우드 시대의 도래 (Trend & Landscape) | – 글로벌 AI·클라우드 트렌드 분석 – Hyperscaler 3사 전략 비교 (AWS·Azure·GCP) – AI Native 인프라의 부상과 조직 변화 |

| Part 2 | 주요 AI 클라우드 서비스 아키텍처 이해 | – CSP별 AI 생태계 구조 (Bedrock, Vertex, AI Studio) – 서비스별 아키텍처 비교 및 도입 기준 – RAG·AutoML·AI Foundry 등 차별화 요소 |

| Part 3 | AI 클라우드 활용 시나리오 | – LLM 기반 고객지원·문서자동화 사례 – Generative AI 콘텐츠/코드 생성 실습 – ML 기반 예측·이상탐지·이미지분석 시나리오 |

| Part 4 | AI 클라우드 도입 전략 및 거버넌스 | – 비용 최적화 및 GPU 리소스 확보 전략 – 데이터 보안·프라이버시·AI 법규 대응 – AI 거버넌스·조직 역량 강화 전략 |

| DAY 2 | ||

| Part 5 | AI 클라우드 기반 서비스 기획 및 바이브코딩 실습 | – GPT·Claude 기반 아이디어 발상 및 프롬프트 설계 – Cursor+GitHub로 AI 웹앱 기획 및 MVP 개발 – 팀별 AI 앱 기획서 및 기술명세 작성 |

| Part 6 | AI 클라우드 앱 배포 및 서버리스 운영 실습 | – Container vs Serverless 구조 비교 – Dockerfile 작성 및 클라우드 배포 실습 – GitHub Actions 기반 CI/CD 자동화 구성 |

| Part 7 | AI 클라우드 아키텍처 보고서 작성 및 성과 공유 | – 클라우드 아키텍처 다이어그램 및 운영 보고서 작성 – 비용·보안·운영 고려사항 문서화 – 팀별 결과 발표 및 피드백 세션 |

🧩 학습 방식

- 🧠 Trend + Hands-on + Report Integration

(산업 트렌드 이해 → 실습 → 결과물 보고서화) - ⚙️ AI 실습 중심 도구

AWS Compute: EC2 > EKS > Lambda, API Gateway / AWS AI: SageMaker, Bedrock / AWS Serverless Deployment: Amplify - 🎯 성과물 기반 평가

팀별 “AI 클라우드 도입 분석 보고서 + 배포된 웹앱 링크” 제출

🎯 기대 효과

| 구분 | 주요 성과 |

|---|---|

| 🔍 전략적 인사이트 확보 | 글로벌 AI 클라우드 트렌드 및 CSP별 기술 구조 이해 |

| 🧩 기획·개발 통합 역량 강화 | AI 서비스 기획 → 코드 빌드 → 배포 전 과정을 실습 |

| ⚙️ 기술 실무력 향상 | GPT/Claude API, Cursor IDE, 서버리스 배포 등 실전 스킬 습득 |

| 💰 운영·비용 최적화 이해 | 클라우드 리소스 활용 효율화 및 보안·거버넌스 인사이트 확보 |

| 🧭 AI 클라우드 아키텍처 문서화 역량 확보 | 기술 보고서 및 아키텍처 다이어그램 작성 능력 향상 |

🧱 교육 산출물 (수강생 결과물)

- AI 서비스 기획서 + 기술명세서 (Prompt·기능·UI 설계 포함)

- AI 웹앱 MVP (GitHub Repo + 배포 URL)

- AI 클라우드 아키텍처 보고서 (비용·보안·운영 포함)

- 발표용 슬라이드 & 팀별 결과 요약 시각자료

📘 AI 앱 서비스 멀티 & 하이브리드 클라우드 배포·운영 기획서 목차 (모범안)

(Modern Cloud Architecture + Enterprise AI Adoption 기준)

AI 클라우드 도입 기획 특화 GPTs의 응답 결과 비교

https://www.notion.so/GPTs-AI-2ae915d11a8b80d68c86da3c9b093a53?source=copy_link

1. Executive Summary (개요 및 추진 배경)

1.1 프로젝트 개요

1.2 추진 배경 및 필요성

1.3 글로벌 AI·클라우드 트렌드 (GenAI, LLM, Agent)

1.4 기업이 해결해야 할 핵심 문제 정의

1.5 기대 효과 및 성공 지표(ROI, 생산성, 비용절감, 품질 개선)

2. 기업 AI 도입 전략 및 LLM 내재화 로드맵

2.1 엔터프라이즈 GenAI 도입 패턴(Use Case → POC → Pilot → Scale)

2.2 LLM 내재화를 위한 3단계 전략

- 모델 활용 단계(Commercial API 활용)

- 모델 최적화 단계(Fine-tuning, RAG)

- 모델 자립 단계(Self-hosting, On-prem, Private LLM)

2.3 조직 구성(Cloud 팀, MLOps 팀, AI COE/PMO)

2.4 교육·역량 개발 전략 (Developer → Prompt Engineer → AI Agent Engineer)

3. 아키텍처 요구사항 정의 (Requirements)

3.1 비즈니스 요구사항

3.2 기능 요구사항 (LLM 기반 AI App 기능 명세)

3.3 비기능 요구사항(NFR: 보안, 확장성, 고가용성, 비용, 규제)

3.4 데이터 요구사항 (정제, 거버넌스, 민감정보 관리)

4. 현대적 클라우드 아키텍처 구성 요소 분석

4.1 모범 아키텍처(Well-Architected Framework) 개요

- AWS, Azure, GCP 공통 핵심 기둥

4.2 AI Native Architecture의 정의

4.3 멀티클라우드 및 하이브리드 클라우드 구성 원칙 - Cloud + On-prem + Edge 통합 모델

4.4 핵심 구성요소 - API Gateway

- Serverless / Containers / VM

- Data Lake & VectorDB

- Model Serving & Inference Gateway

- Observability / Security / DevOps

4.5 엔터프라이즈 네트워크·보안 아키텍처 (VPC, Private Link, VPN, Zero Trust)

5. LLM 기반 AI 앱 서비스 아키텍처 (추천 설계안)

5.1 전체 Reference Architecture (멀티·하이브리드 기반)

5.2 주요 구성 요소

- RAG (Embedding → Vector Search → Retrieval → Reranker → LLM)

- Agent Workflow (Planning → Tools → Memory → Action)

- Model Router (OpenAI, Anthropic, Azure OpenAI, Vertex AI)

- Feature Store & Prompt Store

5.3 Deployment Topologies - Cloud Native 배포

- On-prem Model Serving

- Private LLM (Self-hosted Llama, DeepSeek, Mistral 등)

5.4 LLM 보안 구조 - 데이터 프라이버시

- Access Control / API Governance

- Model Safety Layer(Moderation, Sanitization)

6. 멀티 & 하이브리드 클라우드 배포 전략

6.1 Public Cloud 기반 배포 전략(AWS, Azure, GCP 비교 정리)

6.2 Hybrid Cloud 전략

- On-prem → Cloud 오케스트레이션

- Private LLM → Cloud Scaling 구조

6.3 Multi Cloud 전략 (Type A/B/C)

6.4 컨테이너 기반 확장(EKS/AKS/GKE + Istio/Linkerd)

6.5 Serverless + Container + Edge 혼합 전략

7. 운영(Operations) & MLOps/LLMOps 전략

7.1 MLOps vs LLMOps 개요

7.2 모델 버전 관리(Model Registry)

7.3 RAG 파이프라인 모니터링

7.4 Prompt Lifecycle Management

7.5 LLM Observability (Prompt Trace, Token Usage, Latency, Hallucination Monitoring)

7.6 비용 최적화 전략

- Token/Inference Cost Optimization

- Storage, Network, Compute Tuning

7.7 SRE 기반 운영 (SLI/SLO/SLA)

8. 데이터 전략(Data Governance & Security)

8.1 데이터 아키텍처(Data Lake, DWH, VectorDB, Indexing)

8.2 개인정보·규제 준수(KISA, GDPR, 내부 보안 정책)

8.3 엘리트 데이터 거버넌스(카탈로그, Lineage, Quality)

8.4 Prompt/Embedding의 보안 처리

8.5 감사(Audit)·접근제어(IAM/Role/Policy) 설계

9. 개발·배포 파이프라인(DevOps & CICD)

9.1 GitHub Actions / GitLab CI / Azure DevOps

9.2 IaC (Terraform, Pulumi, CloudFormation, Bicep)

9.3 Canary / Blue-Green / Shadow Deployment

9.4 자동 테스트(LLM Prompt Test, Latency Test, Safety Test)

9.5 실시간 장애 대응 전략

10. PoC → Pilot → Enterprise Rollout 단계별 계획

10.1 PoC 범위 정의

10.2 Pilot 사례 및 평가 지표

10.3 전사 확산 전략 (COE, PMO 구성)

10.4 Change Management & Adoption Plan

10.5 리스크 관리 및 단계별 보완 계획

11. 프로젝트 일정 및 예산 계획

11.1 전체 추진 일정(WBS)

11.2 인력 구성 및 역할(R&R)

11.3 클라우드·AI·데이터 구축 비용

11.4 LLM API 비용 예측 모델

11.5 유지관리(OPS) 비용 추정

12. 기대 효과 및 KPI

12.1 업무 자동화 성과

12.2 생산성·품질·속도 개선 지표

12.3 비용 절감 효과

12.4 리스크 감소·보안 강화효과

12.5 지속가능한 AI 역량 확보 지표

13. 결론 및 향후 발전 방향

13.1 AI 플랫폼 고도화 로드맵

13.2 기업 내 AI 각 부서 확산 전략

13.3 LLM Agent 활용한 전사 DX 추진 모델

13.4 Edge AI·온디바이스 모델 등 차세대 기술 연계

🔖 이번 과정의 키워드

Primary Keywords (핵심 키워드)

- AI 클라우드

- 클라우드 기반 AI 서비스

- Azure OpenAI

- Google Vertex AI

- AWS Bedrock

- AI 클라우드 아키텍처

- AI 클라우드 도입 전략

- 생성형 AI 클라우드

- AI 거버넌스

- AI 클라우드 실습

Secondary Keywords (관련 키워드)

- MLOps / PromptOps

- Serverless AI

- Containerized AI

- AI 비용 최적화

- AI 클라우드 보안

- AI Native 인프라

- AI 클라우드 교육

- Cursor IDE 실습

- GPT / Claude API

- AI 클라우드 보고서

참고자료

GS그룹의 AI 클라우드 – MISO AI

GS 그룹의 GenAI PlayGround

https://www.52g.gs/miso

AWS의 AI 전문 클라우드 서비스

AWS의 AI 전문 클라우드 서비스는 생성형 AI, 머신러닝, 자연어 처리 등 다양한 분야를 아우르며, 기업 요구에 따라 통합적이고 확장 가능한 인프라와 소프트웨어 솔루션을 제공합니다.aws.amazon+2

주요 생성형 AI 및 LLM 서비스

- Amazon Bedrock: Anthropic Claude, Mistral, Meta Llama2, Amazon Titan 등 다양한 대형 언어 모델(LLM) API를 제공, 맞춤형 생성형 AI 앱을 쉽게 개발·운영 가능.a-cloud+2

- Amazon Q: 비즈니스용 생성형 AI 비서로 업무 자동화, 질의응답, 문서 및 코드 리뷰 등 지원. Q Developer는 소프트웨어 개발의 생산성 향상을 위해 코드 리뷰 및 테스트 자동화, 문서화 기능 제공.iting+2

- Amazon SageMaker: 머신러닝 모델의 구축, 학습, 배포, 모니터링까지 통합 지원하는 ML 플랫폼. SageMaker Studio는 협업과 실험 관리가 가능한 통합 개발 환경 제공.jibinary.tistory+2

목적별 사전 훈련 AI 서비스

- 음성·자연어 처리:

- Amazon Transcribe(음성→텍스트),

- Amazon Polly(텍스트→음성),

- Amazon Lex(대화형 챗봇).aws.amazon+1

- 문서·비정형 데이터 추출:

- Amazon Textract(문서 내 텍스트, 필기, 데이터 추출),

- Amazon Comprehend(텍스트 인식 및 분석).aws.amazon+1

- 컴퓨터 비전:

- Amazon Rekognition(이미지·동영상 분석·객체 인식),

- Lookout for Vision(제조현장 비정상 감지).aws.amazon+1

- 언어 번역·추천:

- Amazon Translate(자동 번역),

- Amazon Personalize(맞춤형 추천 알고리즘),

- Amazon Forecast(시계열 예측).jibinary.tistory+2

인프라 및 모델 관리 특화 기능

- 최신 컴퓨팅 인스턴스: AI 모델 훈련용 Trainium2, P5e 등, 대규모 클러스터 및 고가용성 데이터 관리 지원.iting

- RAG/Retrieval-Augmented Generation: 기업 데이터와 LLM을 통합해 정확도 높이고 안전성 강화, Bedrock Data Automation 및 Kendra 연동.iting

- 안전한 모델 파인튜닝 및 프라이빗 LLM 운영: 기업용 맞춤형 AI 환경, 규제 준수·보안 강화 기능 내장.a-cloud

Azure의 AI 전문 클라우드 서비스

Azure의 AI 전문 클라우드 서비스는 OpenAI와의 강력한 파트너십을 기반으로, 생성형 AI, 머신러닝, 산업 특화 모델, 개발 환경, 기업용 AI 어시스턴트 등 다양한 분야에 최적화된 솔루션을 제공합니다.jaenung+2

주요 생성형 AI 및 LLM 서비스

- Azure OpenAI Service: GPT-4.5 Turbo, DALL-E 3, Whisper 등 최신 OpenAI 모델을 엔터프라이즈급 보안과 확장성 하에 제공합니다.learn.microsoft+1

- 2025년 기준, 멀티모달 추론, 기업 데이터 연동, 비용 최적화 등 특화 기능이 대폭 강화됐으며, RAG(Retrieval Augmented Generation) 솔루션도 내장되어 있습니다.jaenung+1

- Azure AI Foundry: AI 에이전트, 모델 배포 및 관리, 다양한 데이터 연동, 코드 해석 및 자동화 등 첨단 기능을 제공하는 통합 플랫폼.facebook+1

머신러닝 및 개발 환경

- Azure Machine Learning: 데이터 준비, 실험, AutoML, MLOps(운영 자동화) 등 One-Stop ML 플랫폼입니다.jaenung

- Microsoft Fabric과 연동되어 데이터 분석부터 모델 배포까지 워크플로우를 통합하며, 2025년에는 AutoML과 운영 자동화도 크게 강화되었습니다.jaenung

- Azure AI Studio: 2024년 출시된 통합 AI 개발 환경으로, 코드 없이도 생성형 AI·RAG 시스템 등을 신속하게 구축할 수 있습니다.jaenung

- Azure Copilot Studio: 기업 맞춤형 AI 업무 어시스턴트 개발 플랫폼으로, 비즈니스 시스템 자동화와 확장성 있는 통합 기능을 제공합니다.jaenung

사전 학습된 AI 모델 (Cognitive Services)

- Azure Cognitive Services: 이미지·음성·언어·문서처리 등 50개 이상의 API/모듈로 제공.jaenung

- 의료, 금융, 제조 등 산업별 특화 모델이 발전하여, 멀티모달(텍스트+영상+음성) 처리가 한층 강화됐습니다.jaenung

통합과 비즈니스 활용

- Microsoft 365, Dynamics 365 등 MS 제품군과의 원활한 데이터 연동 및 확장이 탁월해 기업 실무에 빠르게 적용할 수 있습니다.contents.premium.naver+1

- 대표 활용 사례로, 스타벅스의 맞춤형 음료 추천 시스템 구축에 활용되어 모바일 앱 주문이 28% 증가하는 등 실질적 비즈니스 성과를 입증했습니다.jaenung

특징 및 요금

- 요금 정책: 사용량 기반 종량제. 모델·서비스별 세부 단가가 존재(예: OpenAI Service $0.0004~0.024/1K토큰, Copilot Studio 월 $30~50 등).jaenung

- 중소기업 지원: ‘AI for Business’ 프로그램을 통해 크레딧을 지원하며, MS 생태계 사용자에게 최적화된 경험을 제공합니다.jaenung

GCP의 AI 전문 클라우드 서비스

Google Cloud Platform(GCP)의 AI 전문 클라우드 서비스는 2025년 기준, 첨단 하드웨어와 통합 AI 플랫폼을 기반으로 기업 맞춤형 AI 개발, 생성형 AI, 머신러닝 전 과정 관리를 지원하는 혁신적인 솔루션을 제공합니다.

주요 생성형 AI 및 LLM 서비스

- Vertex AI: GCP의 통합 머신러닝 플랫폼으로, 데이터 준비부터 모델 학습, 배포, 모니터링까지 전체 ML 수명 주기를 지원합니다. AutoML, 커스텀 트레이닝, MLOps 기능이 통합되어 있으며, 생성형 AI 모델도 포함되어 빠른 프로토타입 개발이 가능합니다.

- Vertex AI Model Garden: 다양한 최첨단 AI 모델과 LLM, 생성형 AI 모델을 손쉽게 탐색하고 활용할 수 있는 플랫폼입니다. Gemini 2.5 Pro, Flash 모델 등 구글의 최신 AI 모델들이 포함되어 있습니다.

하드웨어 및 인프라

- Ironwood TPU (7세대): 42.5엑사플롭스에 달하는 강력한 AI 전용 하드웨어로, 대규모 AI 연산 및 고성능 모델 실행을 지원합니다. AI 처리 효율성과 비용 최적화를 동시에 추구합니다.

AI 서비스 및 솔루션

- Generative AI App Builder: 최소한의 코딩으로 웹사이트, 챗봇, 검색 엔진을 구축할 수 있는 생성형 AI 서비스로, 기업 데이터와 연동해 맞춤형 AI 앱을 개발할 수 있습니다.

- 기존 AI 및 산업 특화 서비스: Contact Center AI, Document AI, Healthcare AI 등 산업 맞춤 AI 기능 제공, LLM과 통합해 자연어 처리 및 업무 자동화를 강화합니다.

- Dynamic AI Computing: Gemini 2.5 Flash 모델은 쿼리 복잡도에 따라 처리 시간과 비용을 조절하는 ‘생각의 예산’ 개념의 효율적 컴퓨팅을 구현합니다.

특징과 비즈니스 활용

- GCP AI 플랫폼은 전체적인 AI 워크플로우를 하나의 환경에서 통합하여 개발 생산성과 운영 효율성을 극대화하며, 다양한 산업군에 적합한 맞춤형 AI 솔루션을 지원합니다.

- 구글 클라우드 Next 2025에서 강조된 책임 있고 공정한 AI 개발, 윤리적 AI 운영 원칙으로 신뢰성 있는 AI 서비스 제공에 중점을 둡니다.

- 고객 사례와 확장성 높은 생태계를 바탕으로 AI 기반 혁신과 경제 성장에 기여 중입니다.

첫 포스팅: 25.10.30 / 포스트 문의: JUN (naebon@naver.com)